Education & JIAF

![]() HOME >

SimEnglog MetaLab >

Education & JIAF

HOME >

SimEnglog MetaLab >

Education & JIAF

인공지능의 윤리적 결정에 대하여(1). 트롤리 딜레마관리자작성일 22-04-02 00:00

[문제제기]

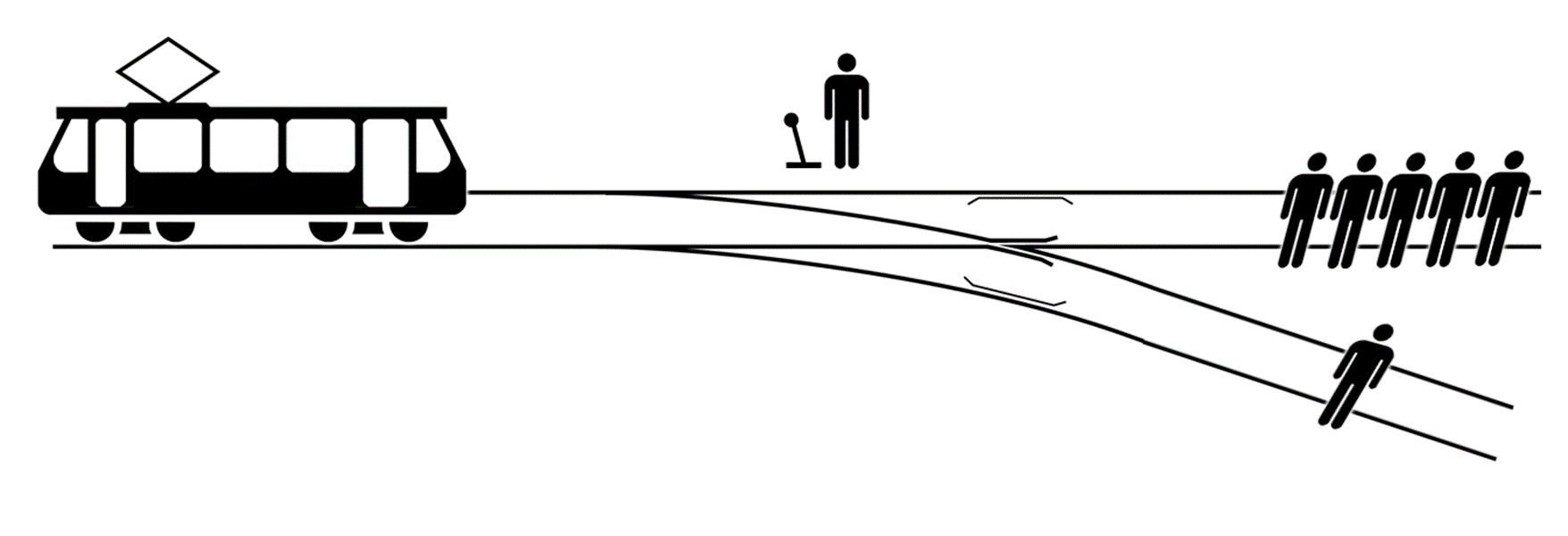

"자율주행자동차 제조업체가 직면한 윤리적 문제와 관련해 가장 많이 언급되는 시나리오 중 하나가 ‘트롤리’ 딜레마다. 이는 사고가 불가피할 때 자동차의 소프트웨어가 어느 방향을 취할지 결정해야 하는 상황을 의미한다. 원래 트롤리 시나리오는 5명이 있는 선로를 향해 달려가는 고장난 열차와 선로 전환기 앞의 한 사람과 관련된 문제로, 전환기 앞의 결정권을 가진 사람이 아무 행동을 하지 않으면 5명의 사람이 죽게 되고, 전환기를 당겨 방향을 돌리면 1명이 죽게 된다. 이제 자율주행자동차 시대에선 전환기 앞의 사람을 자동차의 소프트웨어가 담당하게 된다." 출처 : 테크월드뉴스(http://www.epnc.co.kr)

트롤리 딜레마는 자율주행차가 상용화에 성공하려면 초고도 AI 기술은 물론 ‘윤리적 가치 기준’ 문제까지 판단해야 한다는 복잡성을 단적으로 드러낸다.

아래의 질문 모두, 다른 방법을 쓸 여유는 없고, 법적 책임은 지지 않는 것으로 설정된다. 오직 도덕적인 견해만을 문제삼는 것이다. 응답자는 질문에 대해 (도덕적 관점에서) "허용된다"와 "허용되지 않는다"로 응답하게 되어 있다.

1.광차가 운행 중 이상이 생겨 제어 불능 상태가 되었습니다. 이대로는 선로에 서 있는 5명이 치여죽고 맙니다. 그런데 다행히도 이반이 전철기의 옆에 있고, 전철기를 돌리면 전차를 다른 선로로 보냄으로써 5명을 살릴 수 있습니다. 하지만 문제는 그 다른 선로에 1명이 있어서 그 사람이 치여죽고 맙니다. 어느 쪽도 대피할 시간은 없습니다. 이때 도덕적 관점에서 이반이 전철기를 돌리는 것이 허용됩니까?

5명을 살리기 위해 1명을 죽여도 되는가는 문제가 된다.

공리주의적인 관점에서는 1명을 희생해서라도 5명을 구해야하지만,

의무론을 따르면 누군가를 다른 목적을 위해 수단으로 사용해서는 안 되며, 따라서 아무것도 해서는 안 된다

공리주의의 도덕적 행위는 “최대 다수의 최대 행복을 만족하는 행위”

5명의 사람을 살리면, 이는 5명의 쾌락을 증진하고 1명의 고통을 증진하는 행위, vice versa.

(a) 5명의 쾌락을 증가시키고 1명의 고통을 증가시키는 행위

(b) 1명의 쾌락을 증가시키고 5명의 고통을 증가시키는 행위

(a)와 (b) 중, (a)가 (b)보다 훨씬 최대 다수의 최대 행복에 가까운 행위

칸트의 도덕 법칙이 되기 위한 조건:

‘보편화 정식’(빅데이터?)과 ‘인간 존엄성 정식’

보편화 정식은 개인이 어떤 준칙을 세울 때, 그러한 준칙이 보편적 입법의 원리가 되도록 행위

어떤 국가에서 다수를 위한 소수의 희생을 당연시하는 준칙의 원리를 바탕으로 법을 제정할 수 있는가?

더 나아가 다수의 즐거움을 위해 소수의 인간 존엄성을 짓밟게 되지 않을까?

인권이 별로 중시되지 않던 옛날에는 이러한 일이 많았다.

인간 존엄성 정식:

인간을 수단으로 대하는 와중에도 항상 인간을 그 자체로 목적으로 대우하라는 정식

5명의 인부를 살리기 위한 수단으로 1명의 인부를 이용하는 준칙의 경우,

이 1명은 5명을 위한 수단으로 이용하는 준칙이 된다.

따라서, 인간 존엄성 정식에도 부합하지 않는 준칙이며, 도덕 법칙이 될 수 없다.